Making of AI年賀状ムービー

あけましておめでとうございます。

今年も生成AI年賀状ムービーを作っていろいろな方にお送りしました。

上の画像をクリックすると動画が見れます。

どうやって作ったかをちょろっとお話ししたいと思います。

使ったのはMidjourney、KLING AI、Runway Gen3、Sora、それにPhotoshopのAI機能です。

音楽はSuno AI。

編集はPremiere proとAfter Effectsです。

まず音楽ですね。歌詞は「あけましておめでとう!謹賀新年」だけなので、これをSunoAIのLyricsのところに入れます。

で、頭の中でこれがRUN DMCの”Walk this way”みたいな感じで鳴っていたので、”HIP HOP, RAP,old school”とか入れて楽曲を生成しました。思ったより今っぽい音になりましたね。いくつか出てきた中から気に入ったのをCoverという機能で”male” “female”と入れて男版女版を生成。ボーカルと演奏を別々のトラックに分けるステム機能があるのでそれでバラして、私はAuditionはうまく使えないのでPremiere proでミックスしました。このくらい単純な曲だとPremiereで十分です。

この音楽に絵をつけていきます。

最初のカット、サムライ姿の私がラップしながら歩いているシーン。

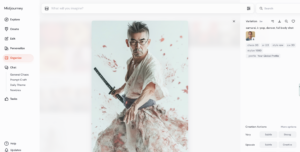

私の顔に似せるためにまず私の写真をアップロード。

元ネタはこれです。これをDiscordにアップしてイメージURLを取得します。Discordでなくてもいいはずなのですが、私はなぜかこのやり方じゃないとうまくいかないのでそうしています。

そこからMidjourney。

“samurai, k-pop, dancer, full body shot”ってプロンプト入れてますね。k-popだったのか。忘れてた。

Midjourneyにはキャラクターリファレンスという機能があります。これが素晴らしい。プロンプトの後ろに半角開けて”–cref”と打ちます。その後ろにまた半角開けて先ほど取得したイメージURLをペースト。すると、すると顔がリファレンスの顔になります。この場合は私の顔。

さらに半角開けて”–cw 30″と入れます。数値は0~100で入力できます。数値が大きいほど顔以外の服などが元の画像に近く、小さくすると元画像よりプロンプトに近くなります。今回はTシャツじゃなくて着流しにしたいので–cw 30にしました。

この手のいわゆるディープフェイクは似たり似なかったり、結構難しいです。今回の私の写真から作った画像はかなりうまくいってますね。真正面からの写真だったのが良かったのかもしれません。左の画像を先に作り、それをリファレンスにして右の画像を作りました。Midjourneyで作った画像をリファレンスにするときは、Createのページの中の画像をプロンプトのウィンドウにドラッグ&ドロップすればいいので楽です。

(と、書いていてふと気がついて今試してみたのですが、写真もプロンプトのウィンドウにドラッグ&ドロップすればキャラクターリファレンスに使えました!知らなかった。いろいろ日々発見があります。Discordを経由する必要がなくなりましたね。)

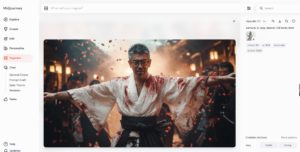

手を広げて歩いている画像、腰の刀の角度がおかしいのでPhotoshopで削除しました。動画化する前にいろいろこの段階で調整します。

このサムライの服、血のようなものが付いてますね。プロンプトには “blood”って書いてないんですが、Midjourneyにはパーソナライゼーションという機能があって、自分好みの絵にしてくれるんです。私はダークな絵が好きなのでAIが勝手に血飛沫を浴びせてくれました(笑)。この機能について書いていると長くなるのでそれはまた。

この血みたいのが付いていると動画化するときにRunwayだと弾かれてしまいます。AIは暴力とセックスに関する表現には規制が厳しいのです。Midjourneyはわりと緩めでこのくらいならOK。今回は大部分の動画をKLINGで生成しています。KLINGは中国の AIで、Runwayよりは表現の規制が緩いようです。

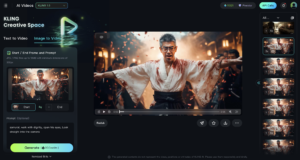

Photoshopで修正したjpg画像をKLINGのImage to Videoのウィンドウにドラッグ&ドロップ。プロンプトのウィンドウに”samurai, walk with dignity, open his eyes, Look straight into the camera”と入れました。Durationを5秒で生成。

5、6回やったらいい感じのができました。KLINGはとてもクォリティの高い動きを作ってくれるのですが、ひとつ問題があって生成時間がかかるんです。5秒の動画1本で10分くらいかかります。なのでこのカットの生成だけで1時間以上かかっています。Runway Gen3はすごく速くて1分くらいでできちゃいますから、そこはKLING弱点ですね。

ただし、ネット上で作業する生成AIのレンダリングは自分のPCには負荷がかかりませんので、KLINGの待ち時間はMidjourneyで次のカットを作ったり他の作業をすることができます。並行していくつもの作業ができてしまうというのはオンラインのすごいところだと思います。

良さげな5秒間のムービーができたら、KLINGのLipsyncという機能でこのサムライにラップをさせます。

最初にSunoで作ったラップのボーカルのみのトラックをKLINGにアップロード。でまたレンダリング約10分。元の動画がうまくできていれば、リップシンクはわりとスムーズにいきます。この機能はRunwayにもあって以前はそっちでやっていました。リップシンクの精度がどちらが高いのかは、まだ比べていないのでわかりません。ただ人物の表情や動きは、私はKLINGを使い始めてまだ2ヶ月くらいですが、RunwayよりKLINGの方が全然いいです。今のところ。

これでファーストカットの動画が完成しました。今回の年賀状ムービーは生成動画が13カットあるので、こういったことを繰り返して、最後はPremiere proとAfter Effectsで編集したりグレーディングしたりノイズを加えたりタイトルを入れたりして完成です。

コンテを描かずに行き当たりばったりで作っているので、生成したけど使わなかったというカットも出てきます。無駄な時間も使うわけですが、このくらいの長さのものだとストーリーを考えるよりいきなり絵を作って並べながら考えた方が面白い気がしています。仕事じゃないので誰にも説明する必要がないですから。

3カット目のこれとかね、なんでこんなのが出来ちゃったのかよく分からないんですよね。「初日の出」とかやろうとしてたんですけどクレージーな絵ができてしまいました。こういうのが面白いですね。

こういう美女系はAIが得意とするジャンルなので安定のカッコ良さです。意外と手間はかかっているのですが、書いてると長くなるのでやめときます。そうそう、最後にSoraのことを少し。

このアニメのヘビ娘の2カットは12月に使えるようになったばかりのSoraで作りました。先日のblogで「3万円も払うのは嫌だ!」みたいなことを書きましたが、やっぱ払って使わないと分からないのでポチってしまいました。3万円。

こういうダンスのような速い動きはSoraじゃないと作れないかもしれません。KLINGやRunwayはゆっくりした動きはきれいに作ってくれますが、激しいのは弱いです。逆にSoraは動きすぎる傾向があります。

プロンプトは”dancing snake, kawaii, anime, k-pop, with backdancers”です。途中でヘビが丸くなったりおかしなことがいくつか起きているのですが、アニメなのであまり気になりません。ハルシネーションもAIの味のうちということでそのまま使っています。

Soraについてはまだ研究不足ですが、今のところImage to Videoは弱いように感じています。プロンプトで指示をしてあとはAIまかせというやり方の方がいいものができる傾向があります。でもSoraを使ってハイクォリティなショートフィルム作っている人もいるので、なんかコントロールする方法があるはずです。もう少し使ってから改めて書こうと思います。

しかし書いてて思いましたが、この文章AIいじってない人には全く意味不明ですね。最後まで読んでくれた根気のある方、ありがとうございました。